Récemment, un de nos lecteurs nous a demandé comment optimiser le fichier robots.txt pour améliorer le référencement.

Le fichier robots.txt indique aux moteurs de recherche comment explorer votre site Web, ce qui en fait un outil de référencement incroyablement puissant.

Dans cet article, nous allons vous montrer quelques conseils sur la façon de créer un fichier robots.txt parfait pour le référencement.

Qu’est-ce qu’un fichier Robots.txt ?

Robots.txt est un fichier texte que les propriétaires de sites Web peuvent créer pour indiquer aux robots des moteurs de recherche comment explorer et indexer les pages de leurs sites.

Il est généralement stocké dans le répertoire racine (également appelé dossier principal) de votre site Web. Le format de base d’un fichier robots.txt ressemble à ceci :

1 2 3 4 5 6 7 | User-agent: [user-agent name]Disallow: [URL string not to be crawled] User-agent: [user-agent name]Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap] |

Vous pouvez avoir plusieurs lignes d’instructions pour autoriser ou interdire des URL spécifiques et ajouter plusieurs plans de site. Si vous n’interdisez pas une URL, les robots des moteurs de recherche supposent qu’ils sont autorisés à l’explorer.

Voici à quoi peut ressembler un exemple de fichier robots.txt :

1 2 3 4 5 6 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /wp-admin/Sitemap: https://example.com/sitemap_index.xml |

Dans l’exemple robots.txt ci-dessus, nous avons autorisé les moteurs de recherche à explorer et indexer les fichiers dans notre dossier de téléchargement WordPress.

Après cela, nous avons interdit aux robots de recherche d’explorer et d’indexer les plugins et les dossiers d’administration WordPress.

Enfin, nous avons fourni l’URL de notre plan de site XML.

Avez-vous besoin d’un fichier Robots.txt pour votre site WordPress ?

Si vous n’avez pas de fichier robots.txt, les moteurs de recherche exploreront et indexeront quand même votre site Web. Cependant, vous ne pourrez pas leur dire quelles pages ou quels dossiers ils ne doivent pas explorer.

Cela n’aura pas beaucoup d’impact lorsque vous démarrez un blog pour la première fois et que vous n’avez pas beaucoup de contenu.

Cependant, à mesure que votre site Web se développe et que vous ajoutez plus de contenu, vous souhaiterez probablement mieux contrôler la façon dont votre site Web est exploré et indexé.

Voici pourquoi.

Les robots de recherche ont un quota d’exploration pour chaque site Web.

Cela signifie qu’ils explorent un certain nombre de pages au cours d’une session d’exploration. S’ils utilisent leur budget d’exploration avant d’avoir fini d’explorer toutes les pages de votre site, ils reviendront et reprendront l’exploration lors de la session suivante.

Cela peut ralentir le taux d’indexation de votre site Web.

Vous pouvez résoudre ce problème en empêchant les robots de recherche de tenter d’explorer des pages inutiles telles que vos pages d’administration WordPress, vos fichiers de plug-in et votre dossier de thèmes.

En interdisant les pages inutiles, vous enregistrez votre quota d’exploration. Cela aide les moteurs de recherche à explorer encore plus de pages de votre site et à les indexer le plus rapidement possible.

Une autre bonne raison d’utiliser un fichier robots.txt est lorsque vous souhaitez empêcher les moteurs de recherche d’indexer une publication ou une page de votre site Web.

Ce n’est pas le moyen le plus sûr de masquer du contenu au grand public, mais cela vous aidera à empêcher le contenu d’apparaître dans les résultats de recherche.

À quoi ressemble un fichier Robots.txt idéal ?

De nombreux blogs populaires utilisent un fichier robots.txt très simple. Leur contenu peut varier en fonction des besoins du site spécifique :

1 2 3 4 5 | User-agent: *Disallow:Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml |

Ce fichier robots.txt permet à tous les robots d’indexer tout le contenu et leur fournit un lien vers les plans de site XML du site Web .

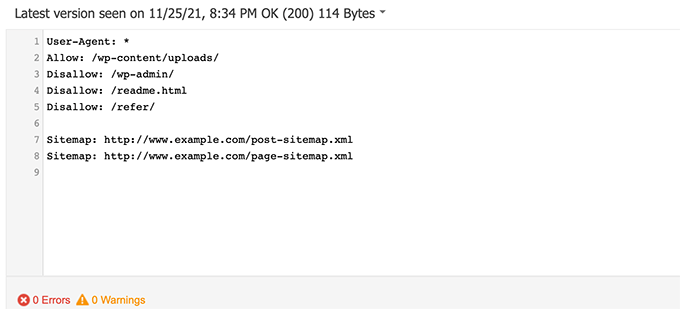

Pour les sites WordPress, nous recommandons les règles suivantes dans le fichier robots.txt :

1 2 3 4 5 6 7 8 | User-Agent: *Allow: /wp-content/uploads/Disallow: /wp-admin/Disallow: /readme.htmlDisallow: /refer/Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml |

Cela indique aux robots de recherche d’indexer toutes les images et tous les fichiers WordPress. Il interdit aux robots de recherche d’indexer la zone d’administration de WordPress, le fichier read-me et les liens d’affiliation masqués .

En ajoutant des plans de site au fichier robots.txt, vous permettez aux robots Google de trouver facilement toutes les pages de votre site.

Maintenant que vous savez à quoi ressemble un fichier robots.txt idéal, voyons comment créer un fichier robots.txt dans WordPress.

Comment créer un fichier Robots.txt dans WordPress

Il existe deux façons de créer un fichier robots.txt dans WordPress. Vous pouvez choisir la méthode qui vous convient le mieux.

Méthode 1 : Modification du fichier Robots.txt à l’aide du référencement tout-en-un

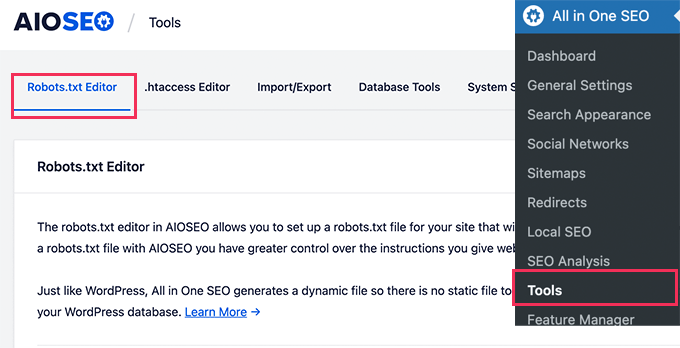

All in One SEO , également connu sous le nom d’AIOSEO, est le meilleur plugin WordPress SEO du marché, utilisé par plus de 3 millions de sites Web.

Il est facile à utiliser et est livré avec un générateur de fichiers robots.txt.

Si vous n’avez pas déjà installé le plugin AIOSEO, vous pouvez consulter notre guide étape par étape sur la façon d’installer un plugin WordPress .

Remarque : Une version gratuite d’AIOSEO est également disponible et dispose de cette fonctionnalité.

Une fois le plugin installé et activé, vous pouvez l’utiliser pour créer et modifier votre fichier robots.txt directement depuis votre zone d’administration WordPress.

Accédez simplement à All in One SEO »Outils pour modifier votre fichier robots.txt.

© aioseo.com

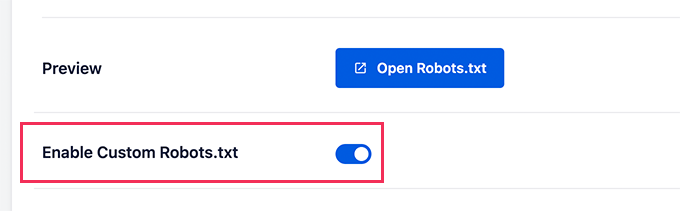

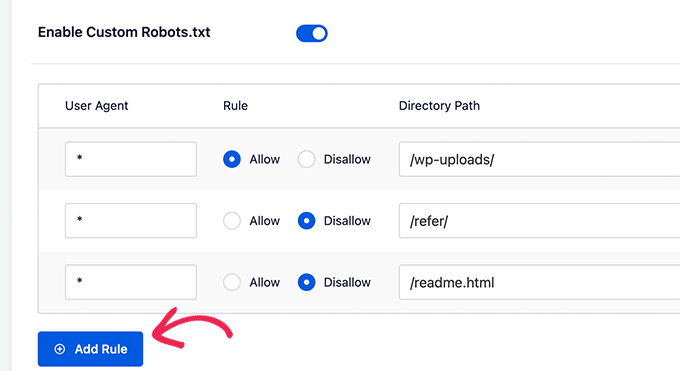

Tout d’abord, vous devrez activer l’option d’édition en cliquant sur le bouton « Activer les robots personnalisés.txt » qui devient bleu.

Avec cette option activée, vous pouvez créer un fichier robots.txt personnalisé dans WordPress.

© aioseo.com

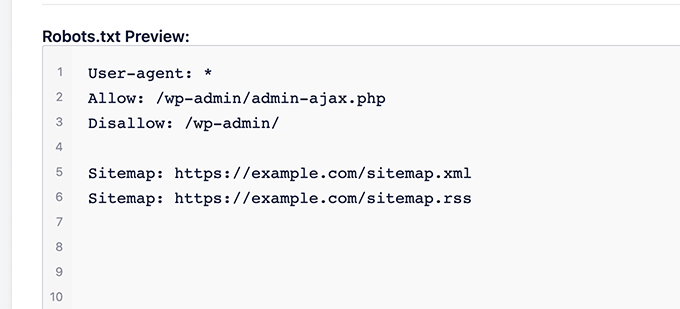

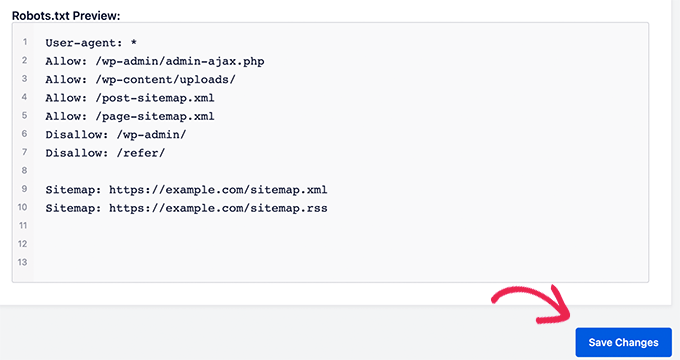

All in One SEO affichera votre fichier robots.txt existant dans la section « Aperçu Robots.txt » en bas de votre écran.

Cette version affichera les règles par défaut ajoutées par WordPress.

© aioseo.com

Ces règles par défaut indiquent aux moteurs de recherche de ne pas explorer vos fichiers WordPress principaux, permettent aux robots d’indexer tout le contenu et leur fournissent un lien vers les plans de site XML de votre site.

Désormais, vous pouvez ajouter vos propres règles personnalisées pour améliorer votre robots.txt pour le référencement.

Pour ajouter une règle, saisissez un agent utilisateur dans le champ « Agent utilisateur ». L’utilisation d’un * appliquera la règle à tous les agents utilisateurs.

Ensuite, indiquez si vous souhaitez « Autoriser » ou « Interdire » l’exploration des moteurs de recherche.

Ensuite, entrez le nom du fichier ou le chemin du répertoire dans le champ « Chemin du répertoire ».

© aioseo.com

La règle sera automatiquement appliquée à votre robots.txt. Pour ajouter une autre règle, cliquez simplement sur le bouton « Ajouter une règle ».

Nous vous recommandons d’ajouter des règles jusqu’à ce que vous créiez le format robots.txt idéal que nous avons partagé ci-dessus.

Vos règles personnalisées ressembleront à ceci.

© aioseo.com

Une fois que vous avez terminé, n’oubliez pas de cliquer sur le bouton « Enregistrer les modifications » pour enregistrer vos modifications.

Méthode 2 : édition du fichier Robots.txt à l’aide de WPCode

WPCode est un puissant plugin d’extraits de code qui vous permet d’ajouter du code personnalisé à votre site Web facilement et en toute sécurité.

Il comprend également une fonctionnalité pratique qui vous permet de modifier rapidement le fichier robots.txt.

Remarque : il existe également un plugin gratuit WPCode , mais il n’inclut pas la fonctionnalité d’éditeur de fichiers.

La première chose à faire est d’installer le plugin WPCode.

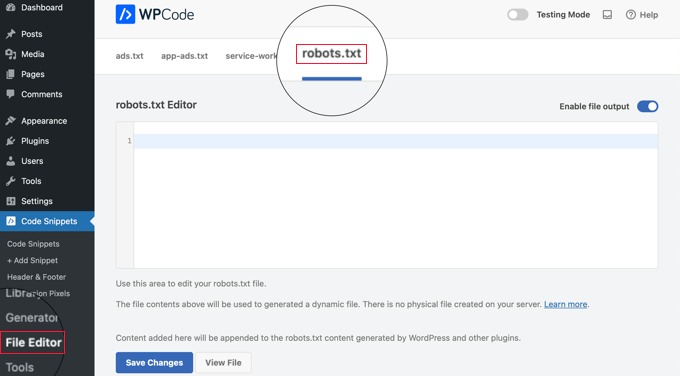

Lors de l’activation, vous devez accéder à la page WPCode »File Editor . Une fois sur place, cliquez simplement sur l’onglet « robots.txt » pour modifier le fichier.

© wpcode

Maintenant, vous pouvez coller ou saisir le contenu du fichier robots.txt.

Une fois que vous avez terminé, assurez-vous de cliquer sur le bouton « Enregistrer les modifications » en bas de la page pour stocker les paramètres.

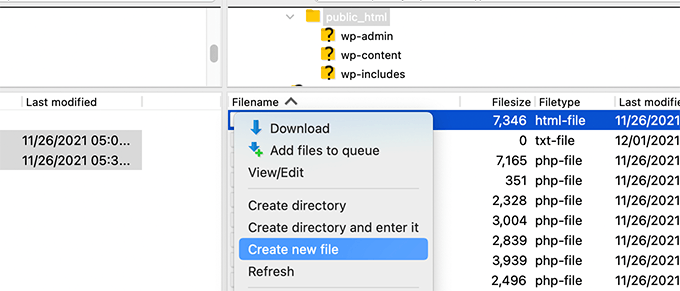

Méthode 3 : Modification manuelle du fichier Robots.txt à l’aide de FTP

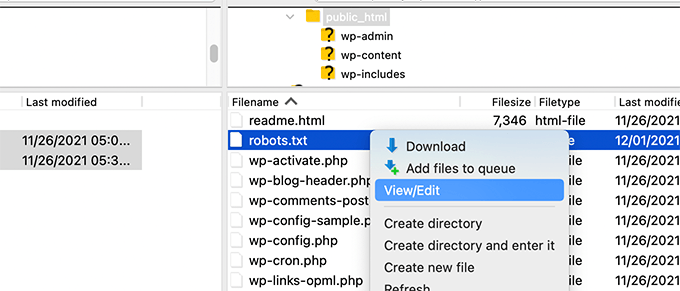

Pour cette méthode, vous devrez utiliser un client FTP pour modifier le fichier robots.txt. Alternativement, vous pouvez utiliser le gestionnaire de fichiers fourni par votre hébergement WordPress.

Connectez-vous simplement aux fichiers de votre site Web WordPress à l’aide d’un client FTP.

Une fois à l’intérieur, vous pourrez voir le fichier robots.txt dans le dossier racine de votre site Web.

Si vous n’en voyez pas, vous n’avez probablement pas de fichier robots.txt.

Dans ce cas, vous pouvez simplement en créer un.

Robots.txt est un fichier texte brut, ce qui signifie que vous pouvez le télécharger sur votre ordinateur et le modifier à l’aide de n’importe quel éditeur de texte brut comme Notepad ou TextEdit.

Après avoir enregistré vos modifications, vous pouvez télécharger le fichier robots.txt dans le dossier racine de votre site Web.

Comment tester votre fichier Robots.txt

Une fois que vous avez créé votre fichier robots.txt, c’est toujours une bonne idée de le tester à l’aide d’un outil de test robots.txt.

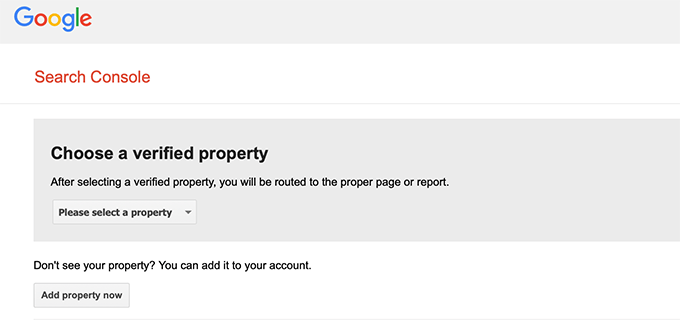

Il existe de nombreux outils de test robots.txt, mais nous vous recommandons d’utiliser celui de Google Search Console .

Tout d’abord, vous devrez lier votre site Web à Google Search Console.

Ensuite, vous pouvez utiliser l’outil de test des robots de la console de recherche de Google .

© google.com

Sélectionnez simplement votre propriété dans la liste déroulante.

L’outil récupérera automatiquement le fichier robots.txt de votre site Web et mettra en évidence les erreurs et les avertissements s’il en trouve.

© google.com

Conclusion

L’objectif de l’optimisation de votre fichier robots.txt est d’empêcher les moteurs de recherche d’explorer des pages qui ne sont pas accessibles au public. Par exemple, les pages de votre dossier wp-plugins ou les pages de votre dossier d’administration WordPress.

Un mythe courant parmi les experts SEO est que le blocage des catégories, des balises et des pages d’archives WordPress améliorera le taux d’exploration et entraînera une indexation plus rapide et un classement plus élevé.

Ce n’est pas vrai. Cela va également à l’encontre des directives aux webmasters de Google.

Nous vous recommandons de suivre le format robots.txt ci-dessus pour créer un fichier robots.txt pour votre site Web.

Dans la même catégorie :

- SEO et visibilité en ligne : Les techniques d’indexation web indispensables à connaitre !

- SEO : Attention ! Ces erreurs dans votre fichier robots.txt peuvent littéralement ruiner votre référencement !

- Google ne passera pas ! 3 méthodes pour rendre vos pages web invisibles aux yeux du moteur de recherche de Mountain View

- 8 solutions faciles pour accélérer l’indexation de votre contenu SEO sur Google

- Sitemap XML Shopify : Qu’est-ce que c’est et comment en soumettre un ?