Si vous bloguez depuis un certain temps, vous avez probablement entendu parler des scrapers de contenu. Le scraping de contenu est à la fois adoré et méprisé. Le scraping de contenu est le processus qui consiste à prendre du matériel unique/original d’un site Web et à le publier sur un autre. Les grattoirs copient généralement l’intégralité de l’information et la font passer pour la leur.

De nombreux créateurs de contenu et propriétaires de sites sont naturellement préoccupés par la perspective d’un grattoir de contenu capturant toutes leurs données. Ici, dans notre article, nous parlerons de ce qu’est le scraping de contenu et des méthodes permettant d’attraper et d’empêcher les scrapers de contenu.

Qu’est-ce que le scraping de contenu ?

Le grattage de contenu de sites Web avec des scripts est connu sous le nom de grattage de contenu. Ces programmes rassemblent des informations provenant de nombreuses sources et les compilent sur une seule page Web.

Certains propriétaires de sites Web utilisent des informations extraites d’autres sites Web plus crédibles, convaincus que l’augmentation du nombre de pages sur leur site est une stratégie intelligente à long terme. Les informations supprimées sont parfois limitées à des extraits avec des liens vers le site source, et d’autres fois, l’article de blog complet est copié mot pour mot.

De plus, les grattoirs de contenu ne dupliquent pas le matériau à la main. Ils utilisent une variété de plugins et de scripts de codage pour reproduire les flux RSS de votre blog et générer du matériel identique en quelques minutes.

Le contenu récupéré, même à partir de sources de haute qualité, peut ne donner aucune valeur supplémentaire aux utilisateurs si le site ne fournit pas de nouveaux services ou contenus de valeur ; dans certaines circonstances, cela peut même constituer une violation du droit d’auteur. Investir l’effort de produire un contenu unique qui distingue le site Web est bénéfique. Cela incitera les visiteurs à revenir et donnera des résultats plus pertinents aux utilisateurs de Google.

Il est important de comprendre la distinction entre la syndication et le scraping. Lorsqu’un autre site Web utilise votre matériel sans votre consentement, cela s’appelle le scraping de contenu.

La syndication, en revanche, se produit lorsque les deux parties conviennent d’utiliser le matériel selon les termes d’un contrat.

Le scraping de contenu affecte-t-il le référencement ?

Le grattage de matériel a un impact négatif sur les sites Web qui ont consacré du temps, de l’argent et des ressources pour générer un contenu unique, car cela abaisse leur classement en matière de référencement et d’autorité Web.

Découvrir que quelqu’un a non seulement volé votre matériel, mais vous surclasse également sur Google pour les requêtes relatives à ce contenu est l’une des expériences les plus désagréables qu’un éditeur puisse vivre.

Pire encore, la source originale du matériel peut disparaître des résultats de recherche, tandis que la version d’un site de scraper peut continuer à bien se classer.

Le Web Scraping est-il illégal ?

De nombreuses personnes ont des perceptions erronées du web scraping. C’est parce que certaines personnes ne respectent pas l’énorme travail qui a été fait sur Internet et en profitent en volant les informations. Scraper du contenu n’est pas illégal en soi ; le problème survient lorsque cela est fait sans le consentement du propriétaire du site et en violation des conditions d’utilisation.

Le scraping de contenu est le processus consistant à copier et coller manuellement le contenu d’un site Web ou à utiliser une application de scraper de site pour collecter le contenu.

Un grattoir peut entraîner de graves pertes financières pour une entreprise en ligne, en particulier s’il s’agit d’une entreprise qui dépend fortement des accords de distribution de contenu.

La majorité du matériel est protégé par le droit d’auteur. En outre, il est malhonnête de présenter à tort même des documents accessibles au public comme des œuvres de création.

Les assauts de scraping sont divisés en trois étapes :

- Les scrapers Web sélectionnent leurs cibles et se préparent à empêcher la découverte d’attaques de scraping en générant de faux comptes d’utilisateurs, en faisant passer leurs robots scrapers malveillants pour des robots légitimes, en masquant leurs adresses IP d’origine, etc.

- Des outils et des méthodes de scraping doivent être utilisés : une légion de robots scrapers est déployée sur le site Web, l’application mobile ou l’API cible. Le volume élevé de trafic de robots surcharge les serveurs, ce qui entraîne un ralentissement des performances du site Web, voire une panne.

- Les grattoirs Web collectent du matériel propriétaire et des enregistrements de base de données auprès de leurs cibles et les stockent dans leurs bases de données pour une étude plus approfondie et une utilisation abusive.

Comment puis-je détecter le scraping de contenu ?

Le plagiat est un problème qui sévit sur Internet depuis un certain temps. Vous avez passé beaucoup de temps et de travail à générer du matériel de haute qualité. Cependant, il y a toujours un autre site Web désireux de le prendre et de le faire passer pour le leur. Il ne vous a pas été donné gratuitement. Et vous avez le droit légal de le défendre. Voyons comment attraper les scrapers de contenu avant de discuter de la façon de les gérer.

Effectuer une recherche Google

Il s’agit de la méthode la plus simple pour localiser les scrapers de contenu. Tout ce que vous avez à faire est d’utiliser les titres de vos blogs dans une recherche Google. Bien que cela puisse sembler une façon terrible de les découvrir, il y a de fortes chances que vous en tombiez sur quelques-uns.

Rétroliens

Les grattoirs directs qui récupèrent le contenu de votre site Web peuvent être détectés à l’aide de rétroliens. Les rétroliens devraient, en théorie, vous conduire vers des sites Web qui ont plagié votre travail. Par rapport aux autres CMS, les rétroliens sont plus répandus sur WordPress. Cependant, avoir des trackbacks sur votre site ne garantit pas que vous serez bien classé ou bénéficierez de la connexion. La clé est de se connecter au sein du site avec un texte d’ancrage riche qui peut être extrait pour le jus de lien.

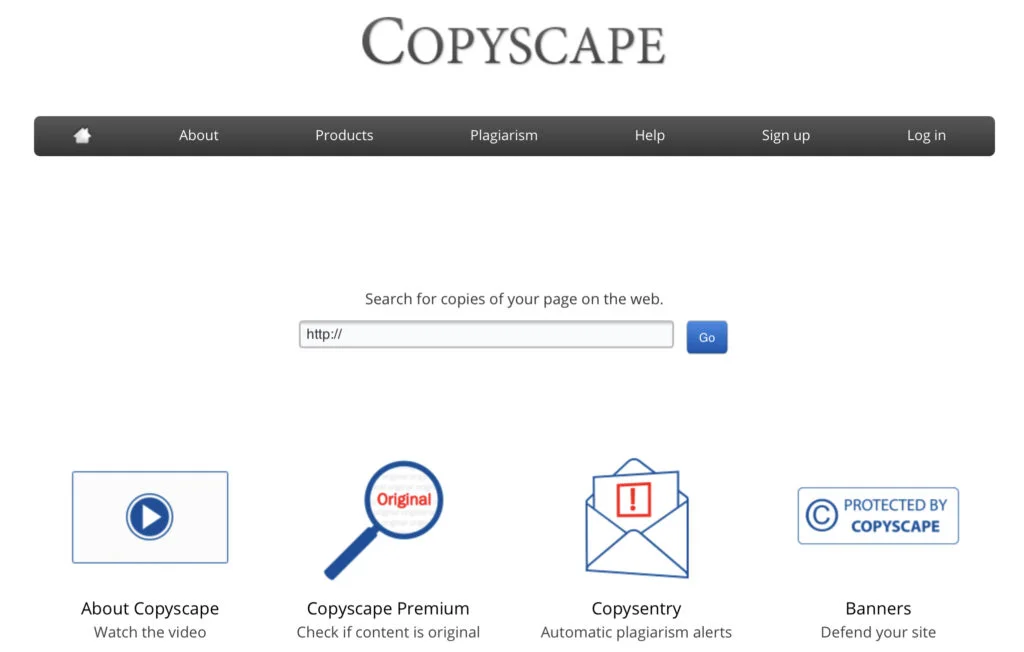

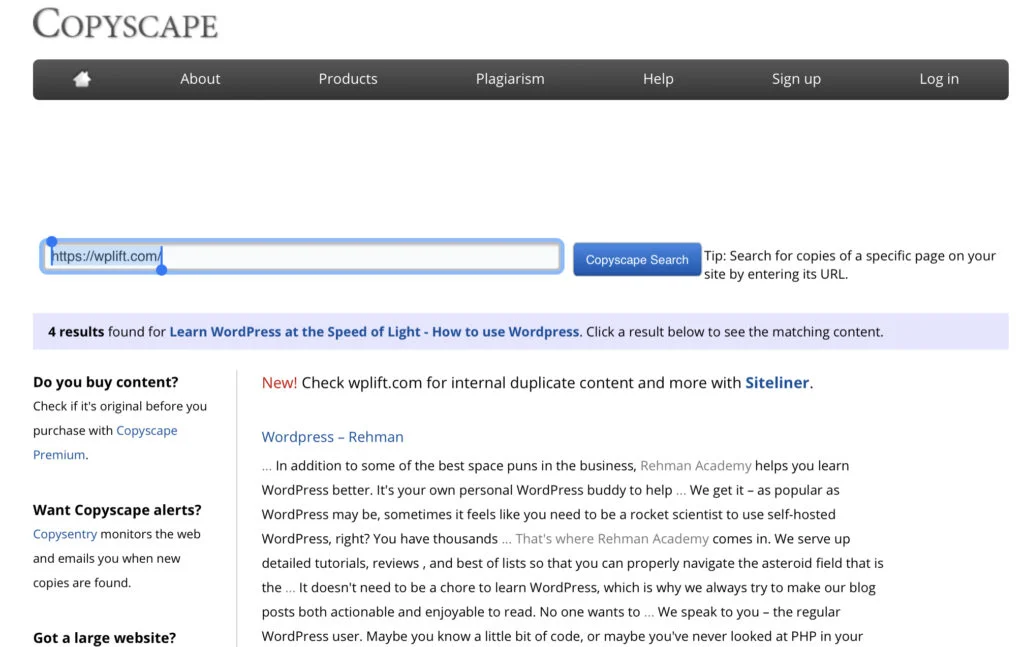

Copyscape

Copyscape est une application anti-plagiat qui vous permet de voir où des copies illégales de votre travail sont apparues sur Internet. Le vérificateur de plagiat est entièrement gratuit et simple à utiliser.

- Pour vérifier le plagiat, rendez-vous sur le service gratuit de Copyscape.

- Collez le lien dans la barre de recherche et appuyez sur go.

Vérifiez s’il y a des retours dont vous devriez vous préoccuper. Restez cool et ne réagissez pas de manière excessive si vous pensez que votre matériel a été abusé.

Le vérificateur de plagiat Copyscape recherche des informations identiques en ligne, mais il ne décide pas quelle page est “l’originale” ou si le contenu a été extrait d’une autre. Lorsqu’une correspondance est découverte, il est possible qu’un site Web en ait plagié un autre, qu’une page en cite légalement une autre, que les deux pages citent la même source externe ou que des termes identiques apparaissent accidentellement sur les deux pages. Il est de la responsabilité de l’utilisateur d’étudier minutieusement chaque cas et d’évaluer la nature de la ressemblance découverte. Pour plus d’informations sur la détection et la réaction au plagiat en ligne, lisez le Guide du plagiat en ligne de Copyscape.

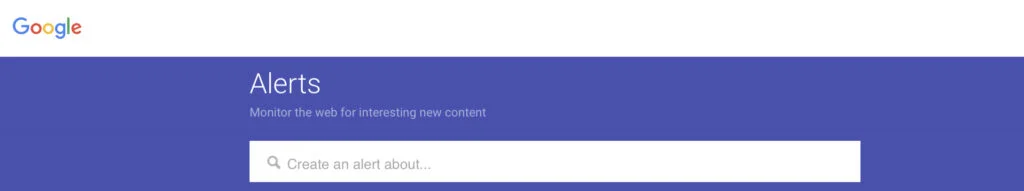

Alertes Google

L’un des meilleurs outils gratuits de Google, Google Alerts, est une merveilleuse méthode pour être alerté chaque fois qu’un certain terme est indexé sur Google. C’est fantastique pour trouver des références de marque, mais c’est aussi bon pour trouver des scrapers de contenu.

Vous pouvez configurer une alerte Google pour le titre exact de votre message chaque fois que vous le publiez. Vous serez informé si quelqu’un gratte du matériel et publie un message avec le même titre.

Vous pouvez également créer une alerte pour une seule phrase unique de votre publication. Cela peut également vous aider à les localiser.

- Aller à Google Alert

- Entrez un sujet que vous souhaitez suivre dans la case du haut.

- Cliquez sur Afficher les options pour modifier vos préférences. Vous avez la possibilité de modifier :

- À quelle fréquence recevez-vous des notifications ?

- Les types de sites Web que vous rencontrerez

- Votre langue

- Combien de résultats souhaitez-vous afficher quelle que soit la région du monde pour laquelle vous souhaitez obtenir des informations

- Quels comptes sont notifiés ?

- Créez une alerte en cliquant sur le bouton Créer une alerte. Lorsque nous découvrons des résultats de recherche correspondants, nous vous envoyons un e-mail.

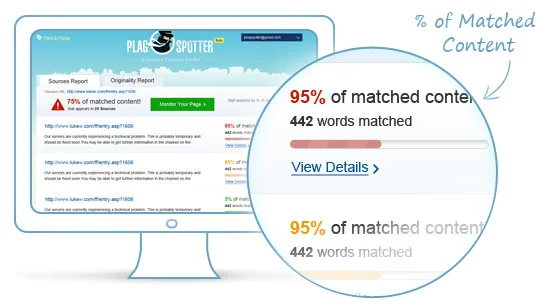

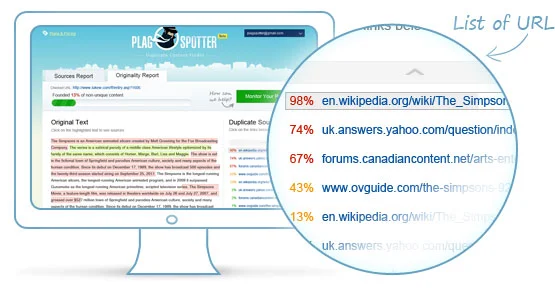

Plagspotteur

L’utilisation de l’outil de détection de contenu en double Plagspotter pour gérer le contenu de votre site est l’une des étapes les plus bénéfiques que vous puissiez faire. Vous pouvez identifier les personnes qui ont copié ou republié votre matériel et améliorer votre propre contenu en le rendant moins similaire à d’autres sites Web en utilisant la technologie unique de détection de plagiat de PlagSpotter. Cela améliorera non seulement le contenu de votre site, mais augmentera également votre lecture et votre audience.

- Entrez votre URL et cliquez sur le bouton Rechercher des copies pour recevoir une liste complète des sources (URL) qui republient immédiatement votre matériel.

- Consultez une liste complète des URL qui incluent votre contenu correspondant, ainsi que l’endroit où le contenu correspondant est hébergé, une fois que vous avez reçu le rapport sur le contenu dupliqué.

- Consultez une vue complète, phrase par phrase, de la quantité de texte dupliqué sur votre site Web, ainsi que du nombre de sites externes incluant chaque fragment exact de votre texte copié, sur la page du rapport sur le contenu dupliqué.

- Intégrez le logo PlagSpotter « Protégé par PlagSpotter » sur votre site Web pour dissuader les plagiaires de copier votre travail. Si votre contenu est volé, suivez nos instructions pour le supprimer des sites Web indésirables.

Outil Google pour les webmasters

L’outil Google pour les webmasters est un outil fantastique pour trouver des grattoirs pour le contenu de votre site Web. Vous devriez regarder les sites qui renvoient vers vous, et si les liens proviennent de publications fréquentes, il est probable qu’il s’agisse de fans inconditionnels de blogs, de followers sur les réseaux sociaux ou de scrapers.

Comment puis-je arrêter les grattoirs de contenu ?

Les grattoirs ont compris comment vivre du travail des autres sans avoir à donner de crédit. Cela implique que vous devez les supprimer. Voyons comment gérer les scrapers de contenu maintenant que vous savez comment les attraper.

Ajouter des liens

Au sein de votre site Web, il est essentiel de créer autant de liens internes que possible. Ces liens dirigeront les lecteurs vers des articles antérieurs pertinents pour celui qu’ils sont en train de lire.

L’interconnexion permet à vos visiteurs de localiser plus facilement de nouveaux contenus et aux moteurs de recherche d’analyser votre site.

Cela peut également être utile lorsqu’il s’agit de scraper du contenu. Ces liens peuvent être conservés si quelqu’un prend votre matériel. En conséquence, vous pourrez peut-être obtenir des connexions gratuites à partir de leur site Web.

L’ajout de liens vers des mots-clés qui incitent les lecteurs à cliquer dessus peut vous aider à réduire votre taux de rebond. En même temps, lorsque cet article est gratté, l’audience du site Web du grattoir peut également cliquer dessus. Vous finirez également par arracher le public du grattoir de cette façon.

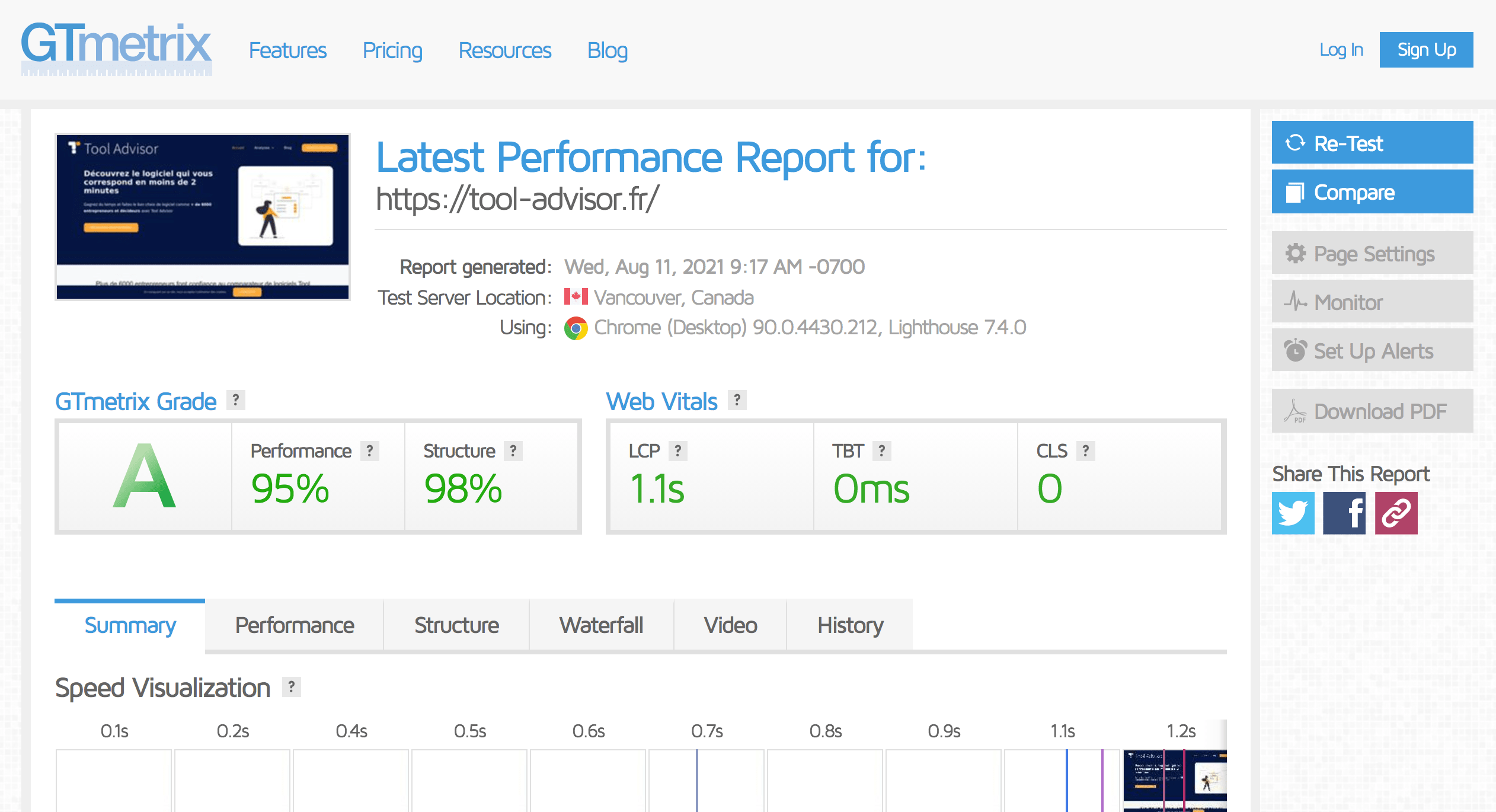

Bloquer les IP de Scraper connu

Vous pouvez même aller plus loin et bloquer les adresses IP des scrapers. Une fois que vous avez identifié le trafic anormal, vous pouvez utiliser des fichiers.htaccess ou des règles Nginx pour le restreindre sur votre serveur. Si vous êtes un client Kinsta , notre équipe d’assistance peut également vous aider à bloquer les adresses IP. Si vous utilisez un WAF tiers comme Sucuri ou Cloudflare, vous pouvez également les utiliser pour restreindre les adresses IP.

Bloquer IP en utilisant Sucuri

- Dans la colonne Interdire les adresses IP, cliquez ici et entrez l’adresse IP que vous souhaitez mettre sur liste noire.

- Une fois que vous avez mis l’adresse IP dans la case, cliquez sur Liste noire pour l’ajouter à la liste noire.

Mettre l’accès à la connexion

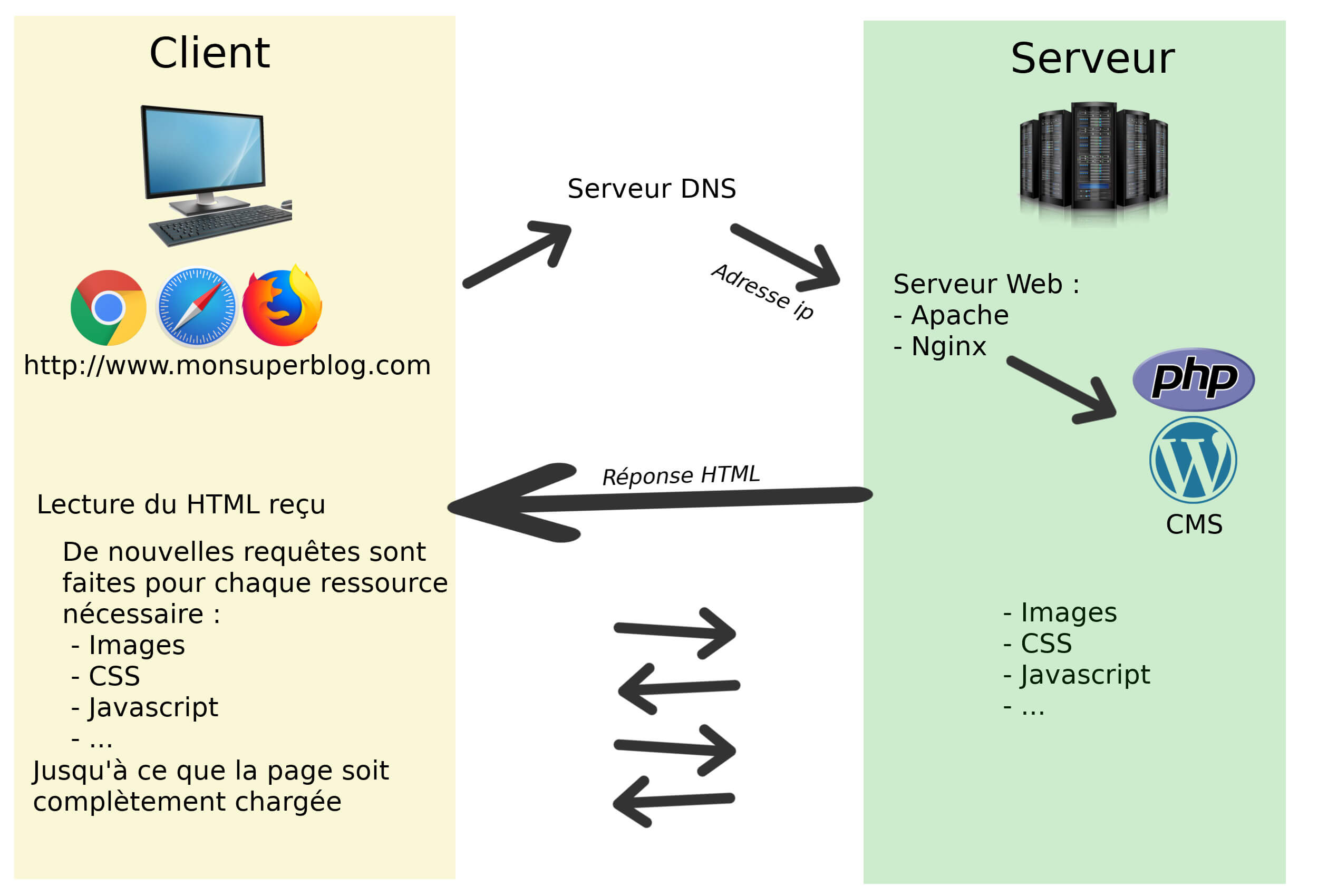

HTTP est un protocole sans état, ce qui signifie qu’aucune information n’est conservée d’une requête à l’autre, cependant, la plupart des clients HTTP (tels que les navigateurs) enregistrent des cookies de session.

Cela implique que si un scraper consulte une page sur un site Web public, il n’a généralement pas besoin de s’identifier. Cependant, si le site Web est protégé par un mot de passe, le scraper doit fournir des informations d’identification (le cookie de session) avec chaque demande afin d’accéder au contenu, qui peut ensuite être retracé pour découvrir qui scrape.

Cela n’arrêtera pas le grattage, mais cela vous offrira des informations sur qui accède à votre contenu de manière automatique.

Modifiez régulièrement le code HTML de votre site Web

Les scrapers s’appuient sur la détection de modèles dans la syntaxe HTML d’un site, qu’ils utilisent ensuite comme indices pour guider leurs scripts vers les données correctes dans la soupe HTML.

Vous pourriez être en mesure d’ennuyer suffisamment le scraper pour qu’il abandonne si le balisage de votre site change régulièrement ou est complètement incohérent.

Cela ne nécessite pas une refonte complète du site Web; la simple modification de la classe et de l’identifiant dans votre code HTML (et les fichiers CSS associés) devrait suffire à arrêter la plupart des scrapers.

Vous devez être conscient que vous risquez également de rendre fous les concepteurs de votre site.

HTTP est un protocole sans état, ce qui signifie qu’aucune information n’est conservée d’une requête à l’autre, cependant, la plupart des clients HTTP enregistrent des cookies de session.

Cela implique que si un scraper consulte une page sur un site Web public, il n’a généralement pas besoin de s’identifier. Cependant, si le site Web est protégé par un mot de passe, le scraper doit fournir des informations d’identification (le cookie de session) avec chaque demande afin d’accéder au contenu, qui peut ensuite être retracé pour découvrir qui scrape.

Cela n’arrêtera pas le grattage, mais cela vous offrira des informations sur qui accède à votre contenu de manière automatique.

Limites de débit d’adresses IP individuelles

Si vous recevez des milliers de requêtes à partir d’un seul ordinateur, il est probable que la personne qui se trouve derrière envoie des requêtes automatisées à votre site Web.

L’une des premières mesures prises par les sites pour lutter contre les scrapers Web consiste à bloquer les requêtes des machines qui les effectuent trop rapidement.

Gardez à l’esprit que certains services proxy, VPN et réseaux d’entreprise affichent tout le trafic sortant comme provenant de la même adresse IP, vous pouvez donc involontairement bloquer un grand nombre d’utilisateurs authentiques qui sont tous connectés via le même ordinateur. Si un scraper dispose de ressources adéquates, il peut contourner cette sécurité en exécutant son scraper sur de nombreuses machines, de sorte que seules quelques requêtes proviennent de chaque machine.

Si le temps le permet, ils peuvent simplement ralentir leur scraper afin qu’il fasse une pause entre les requêtes et semble être simplement une autre personne visitant les URL toutes les quelques secondes.

Désactiver le lien direct d’image

Si vous découvrez que des personnes utilisent votre flux RSS pour obtenir des informations, elles peuvent également utiliser votre bande passante. Ils peuvent prendre des photos de votre site Web pour ce faire.

Pour éviter qu’ils ne le fassent, apportez certains ajustements au fichier .htaccess de votre site Web afin de bloquer les liens dynamiques vers les images.

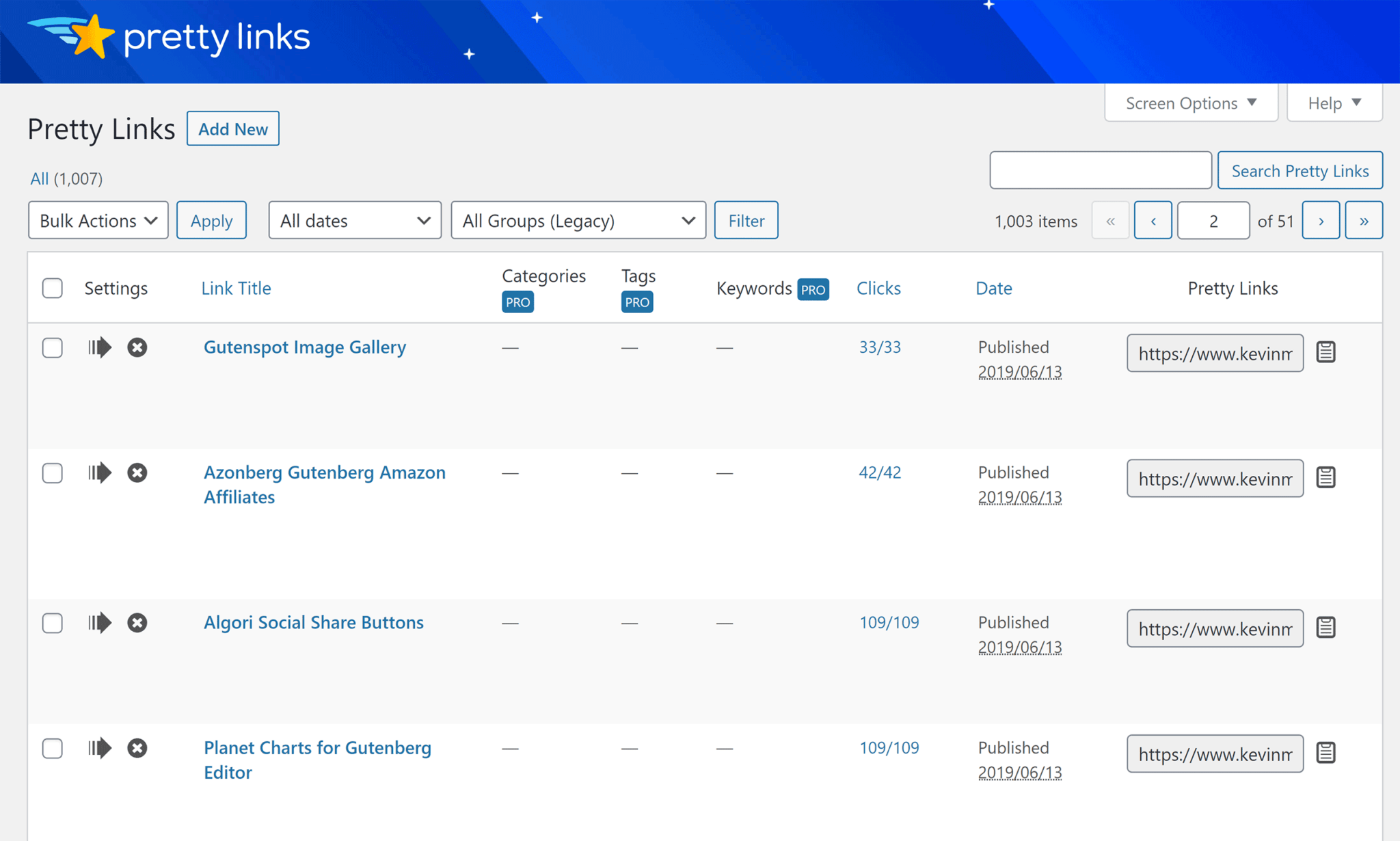

Liens d’affiliation avec des mots-clés

Il y a un risque que vous perdiez des visiteurs clés à la suite du scraping de contenu. Cependant, en ajoutant simplement des liens d’affiliation à des termes spécifiques, vous pouvez en profiter. Des plugins comme SEO Smart Links et Ninja Affiliate peuvent vous aider à automatiser cette procédure.

Bien que vous puissiez perdre certains visiteurs à cause de cela, vous gagnerez toujours des commissions d’affiliation. Vous profitez peut-être de l’audience du scraper sans même vous en rendre compte.

Utilisez le CAPTCHA

Les CAPTCHA sont destinés à distinguer les gens des ordinateurs en posant des tâches simples pour les humains mais complexes à résoudre pour les machines.

Alors que les humains perçoivent les problèmes comme simples, ils les trouvent également très irritants. Les CAPTCHA sont utiles, mais ils doivent être utilisés avec prudence.

Peut-être qu’un CAPTCHA ne devrait être affiché que si un client a effectué des centaines de requêtes au cours des dernières secondes.

Créer une page Honeypot

Un «pot de miel» est un lien vers du matériel fictif qui n’est pas visible pour l’utilisateur moyen mais qui est présent dans le code HTML et apparaît lorsqu’un logiciel analyse la page. Les grattoirs peuvent être détectés et faire gaspiller des ressources en accédant à des pages qui ne contiennent aucune donnée en les détournant vers de tels pots de miel.

Emballer!

Les scrapers peuvent être vaincus de différentes manières. Aucune stratégie n’offre une protection complète, mais en combinant quelques-unes, nous pouvons créer un moyen de dissuasion très efficace.